После прочтения статей вы научитесь: оптимизировать кампании в Excel методами, которые используются в оптимизаторах конверсий; автоматически собирать семантику, сегментировать и создавать объявления; прогнозировать конверсию на базе истории и многое другое.

Темы статей:

- Выгрузка данных из Google Analytics и Яндекс Метрики по API

- Парсинг ключевых слов в Key Collector

- Кластеризация запросов

- Агрегирование данных

- Прогнозирование конверсии для ключевых слов

- Расчет ставок

- Разработка заголовков

- Разработка рекламных кампаний

- Анализ эффективности

Материал сложный и раскрывает только базовые подходы к автоматизации, чтобы задать вам вектор развития.

В прошлой статье мы получили список запросов с конверсиями из Яндекс Метрики, которые теперь нам предстоит распарсить входящие запросы. Парсить будем входящие ключевые слова с частотностью менее 2000, но более 30 запросов в месяц по России.

Что мы делаем?

1) У нас есть запросы с конверсиями, которые нам нужно расширить

2) Мы берем запросы с конверсиями и парсим их входящие запросы, которыми мы их потом и расширим 3) То есть мы создаем базу входящих ключевых слов, из которой подтянем похожие слова к словам с конверсиями. Если слово будет входить в одну группу с фразой с конверсией, то мы его «подтягиваем». 4) На практике можно использовать не только входящие слова, но и любые другие, базу слов можно «расширять» бесконечно, вы ограничены только ресурсами кластеризации. В рамках статьи мы взяли только входящие запросы, чтобы не усложнять ее.

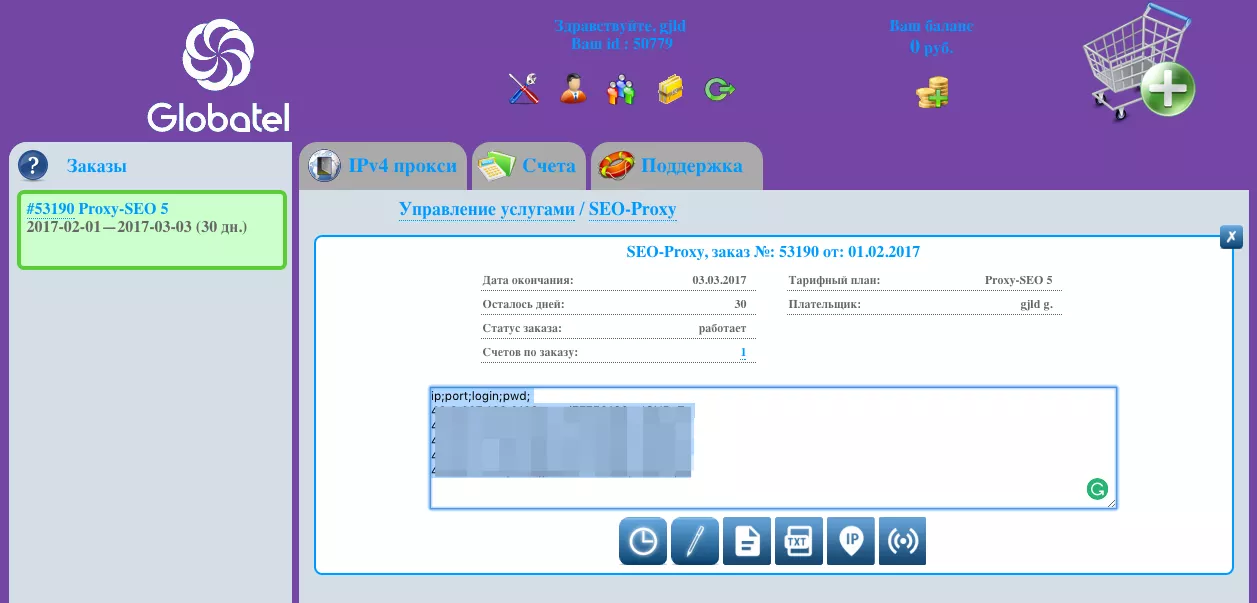

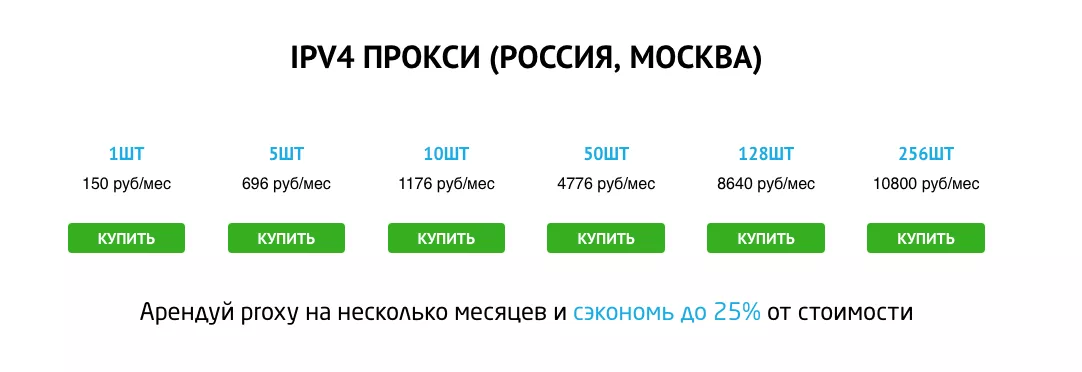

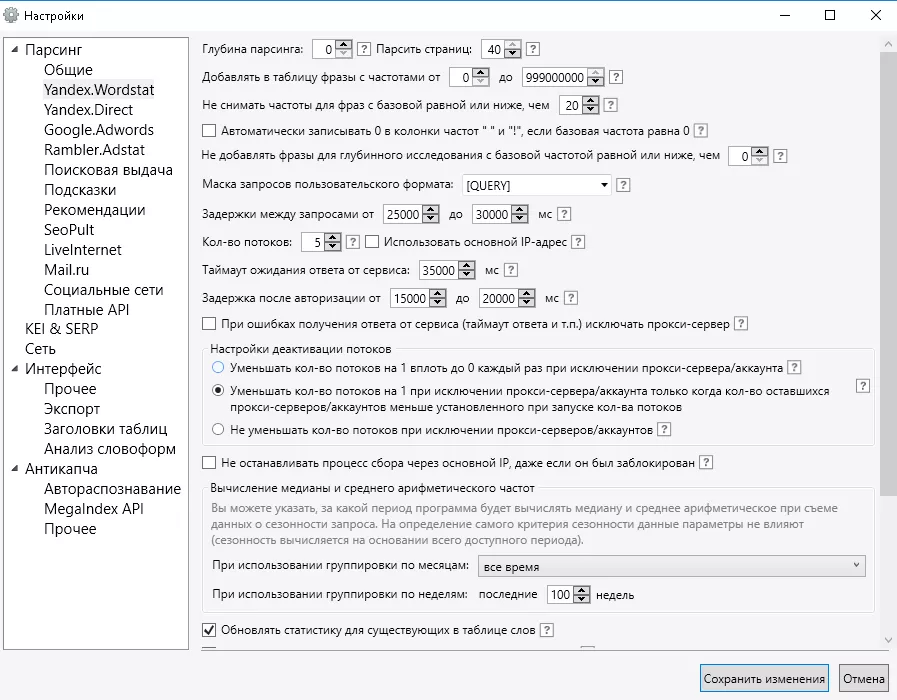

Парсим частотность запросов в Key Collector. Используем прокси с сайта primeproxy.net . Сайт проверенный, вы нам поверьте, мы парсим в промышленных масштабах!

Цены

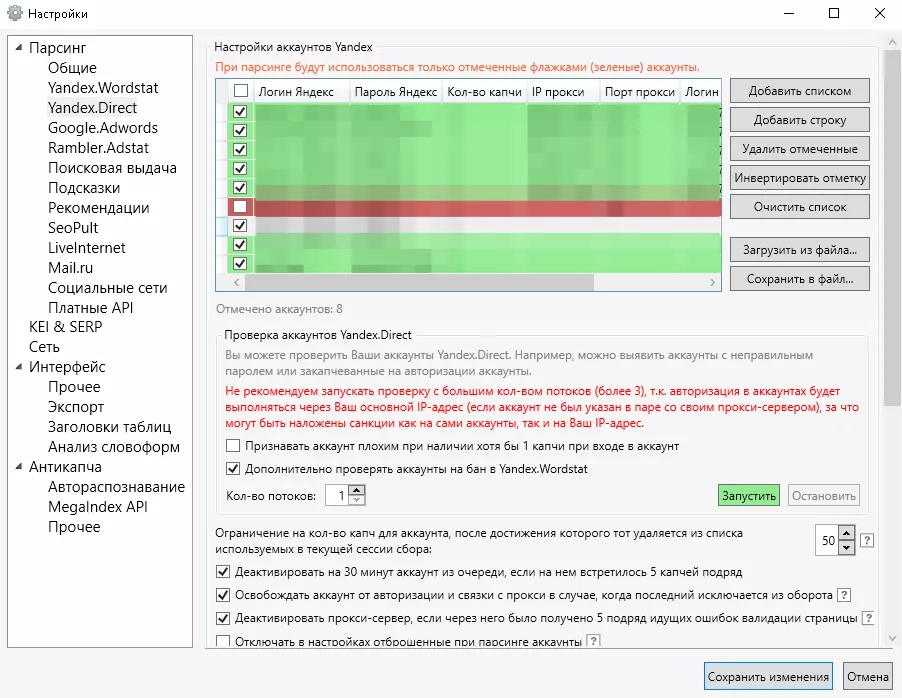

Вставляем полученные прокси в настройки, как на скринах. К каждому IP нужно закрепить аккаунт в Яндекс Директе. В нашем случае мы купили 5 прокси и сможем парсить в 5 потоков. Вставляем адреса в соответствующие поля.

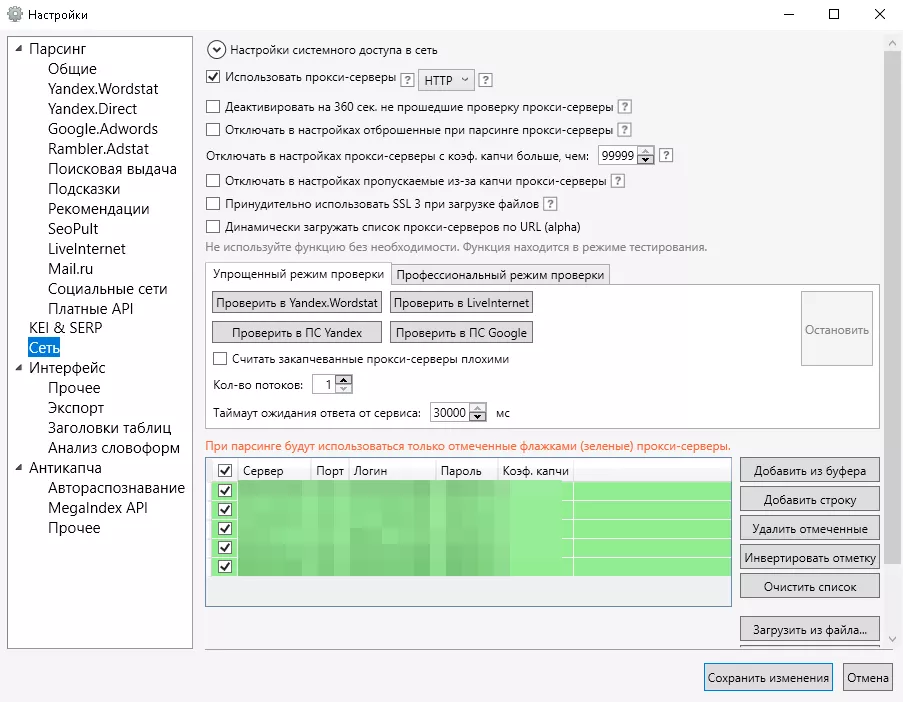

И сюда.

Если у вас много посадочных страниц >1000, то лучше импортировать фразы вместе с ссылками, по которым была конверсия, так как она может пригодиться.

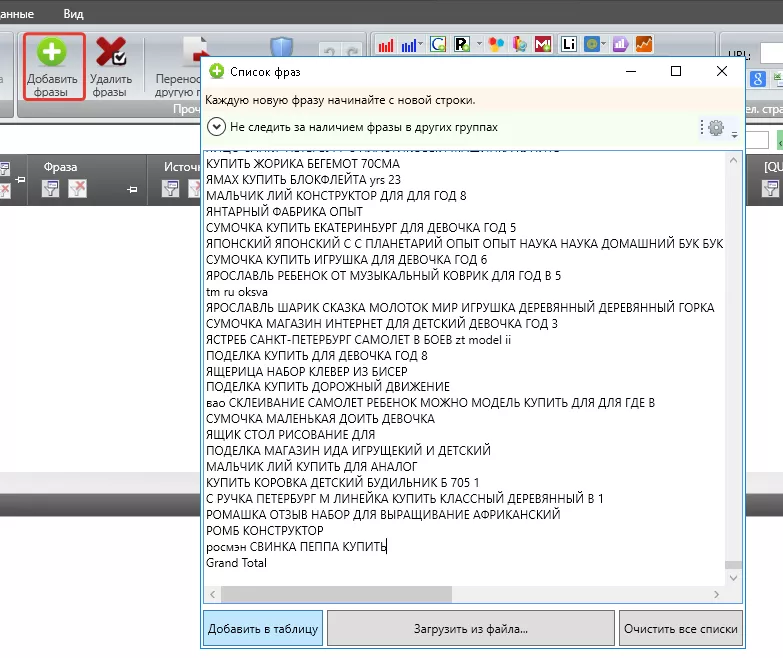

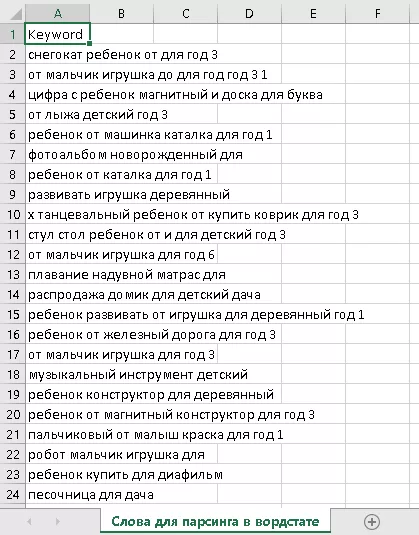

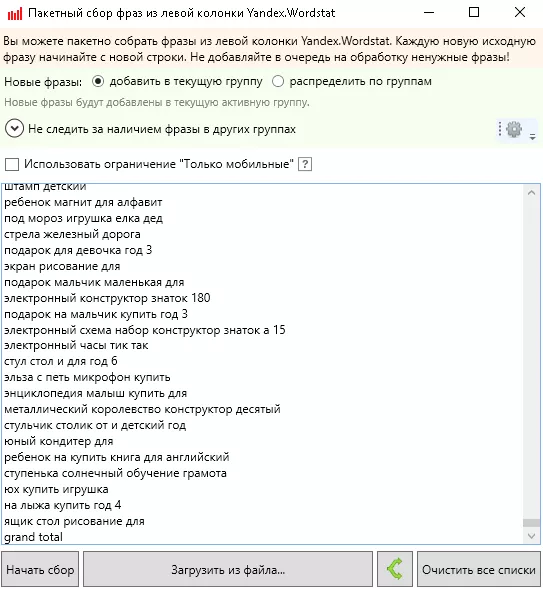

Вставляем слова в Key Collector

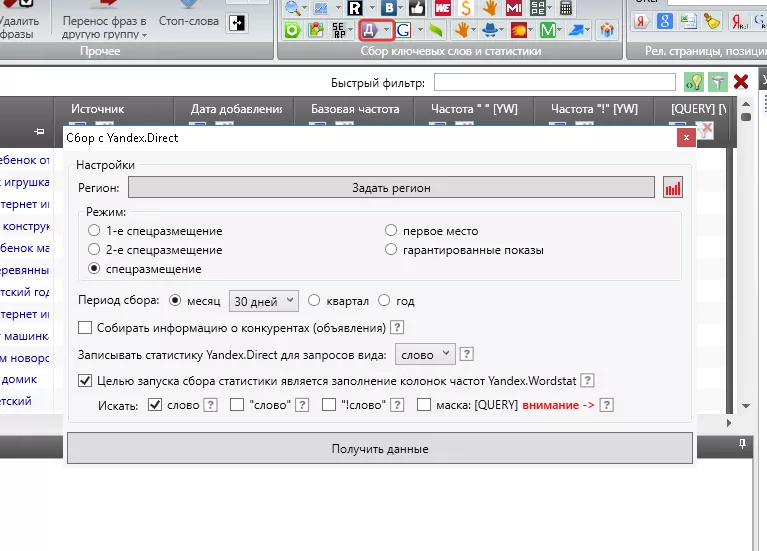

Запускаем парсинг

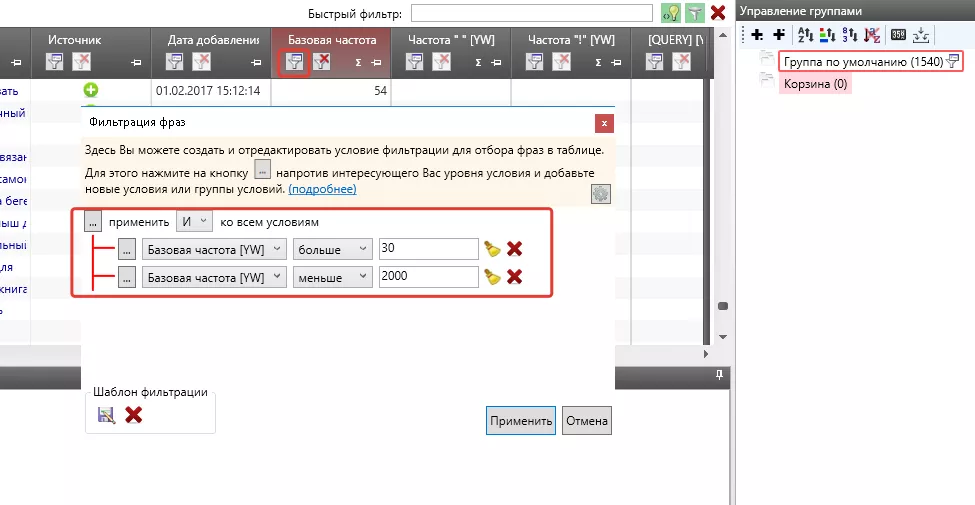

Фильтруем список ключевых слов от 50 до 2000, чтобы распарсить их в вордстате.

Почему именно такие цифры? - Меньше 30 собирать слова нет смысла, их там очень мало - легче просто охватить их задав широкое соответствие, а свыше 2000 слишком много, потребуется много ресурсов на кластеризацию и немного другой подход, который усложнит статью.

Тут одна проблема, у нас 1500 ключевых слов, которые включают входящие запросы и получается так, что мы будем парсить один и тот же массив несколько раз, например, у нас есть слова «купить игрушку танк» и «купить игрушку». Нам не смысла парсить «купить игрушку танк», так как она находится внутри «купить игрушку».

Но как из массива 1500 удалить входящие слова? Готовых решений нет, поэтому пришлось написать свой код на Python.

#!/usr/bin/env python # -*- coding: UTF-8 -*- # импортируем библиотеки import pandas as pd import re # открываем таблицу df = pd.read_excel('Слова для парсинга в вордстате.xlsx', header=0) # в столбике delete пишем delete для входящих ключевых слов df.loc[:,'delete'] = 0 for i in range(len(df)): temp = df.loc[i,'delete'] t = df.copy() for word in df.loc[i,'Keyword'].split(' '): t = t[t['Keyword'].str.contains(word)] for idx in t.index: df.loc[idx,'delete'] = 'delete' df.loc[i,'delete'] = temp # сохраняем таблицу в файл df.to_excel('Слова для парсинга в вордстате.xlsx')

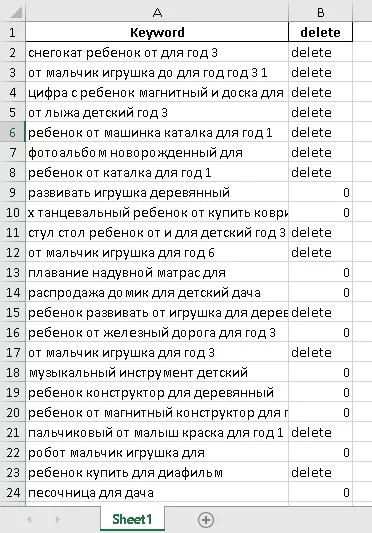

На выходе получаем новый столбик «delete», в котором значение «0» значит верхний запрос, а «delete» входящий - все входящие запросы мы удаляем, а верхние распарсиваем в wordstat'е

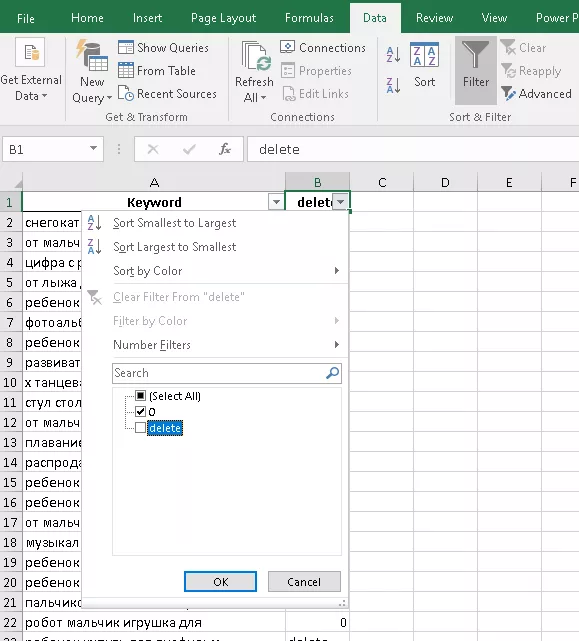

Фильтруем слова со значением «0» и копируем их в кей коллектор, получилось 1000 слов из 1500.

Вставляем в KeyCollector

Для парсинга используем настройки, которые на скрине - мы изменили кол-во потоков на 5, так как у нас 5 прокси и для каждого свой аккаунт в Яндекс Директе.

Все, парсинг запущен, в следующем этапе поговорим о прогнозировании.

Пишите вопросы в комментариях, какие темы было бы интересно раскрыть подробнее? Если у вас есть идеи или советы, то делитесь!